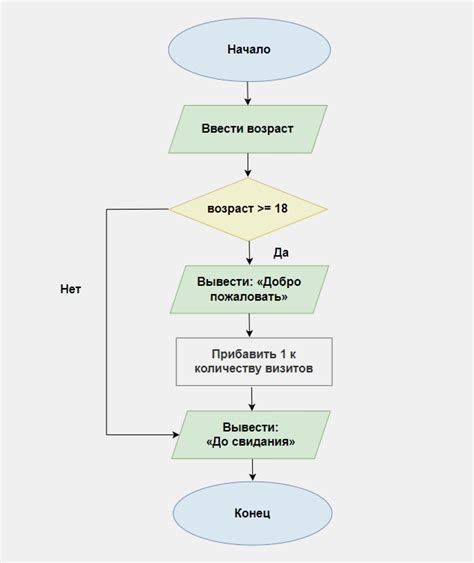

Алгоритм обучения персептрона является одним из основных методов машинного обучения и используется для классификации данных. Он основан на модели биологического нейрона и позволяет создавать и обучать нейронные сети, способные распознавать и классифицировать информацию.

Когда алгоритм обучения персептрона завершает свою работу? Обычно это происходит, когда достигнуто условие остановки, заданное для конкретной задачи. В качестве условия остановки может выступать достижение определенного значения точности классификации или минимизация функции потерь.

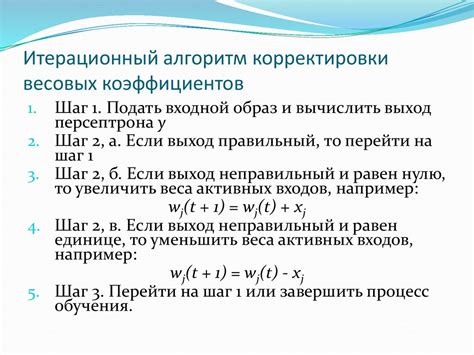

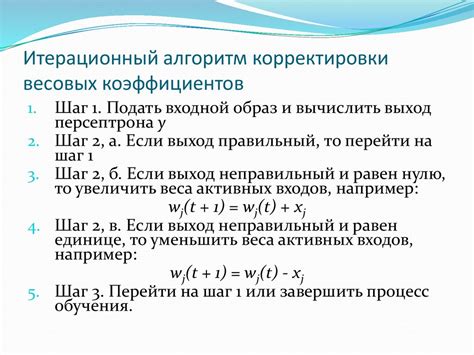

В процессе обучения персептрон постепенно корректирует веса своих связей таким образом, чтобы минимизировать ошибку классификации. Обычно обучение происходит итерационно, на каждой итерации алгоритм вычисляет ошибку и обновляет веса. Этот процесс продолжается до достижения условия остановки.

Условие остановки может быть определено заранее или задано пользователем. Оно зависит от конкретной задачи и требований к точности и быстродействию модели. Некоторые разновидности персептронов могут самостоятельно определять условие остановки на основе изменения ошибки классификации на каждой итерации обучения.

Какое время требуется на завершение работы алгоритма обучения персептрона?

Время, необходимое для завершения работы алгоритма обучения персептрона, может сильно варьироваться в зависимости от различных факторов.

Один из основных факторов - сложность итераций обучения. Если данные сложны или неправильно разделены линией, персептрону может потребоваться больше времени на достижение сходимости. В таких случаях алгоритм может требовать значительных вычислительных ресурсов и занимать большое количество итераций.

Другим фактором, влияющим на время обучения, является размер обучающей выборки. Чем больше примеров в выборке, тем больше времени может потребоваться на обучение персептрона.

Также важным фактором является архитектура самого персептрона. Если персептрон имеет большое количество скрытых слоев или нейронов, то время обучения может значительно увеличиться.

Наконец, скорость обучения - параметр, который может влиять на время обучения персептрона. При низкой скорости обучения алгоритм может сходиться медленно, в то время как слишком высокая скорость обучения может привести к нестабильным и непредсказуемым результатам.

В целом, время, требуемое для завершения работы алгоритма обучения персептрона, будет разным для каждой конкретной задачи и конфигурации персептрона. Однако, с учетом различных факторов, алгоритм обучения персептрона обычно может быть завершен за относительно малый промежуток времени в реальных сценариях обучения.

Сколько итераций требуется для достижения сходимости в алгоритме обучения персептрона?

Количество итераций, необходимых для достижения сходимости, зависит от нескольких факторов:

| Фактор | Влияние на количество итераций |

|---|---|

| Сложность задачи | Чем сложнее задача, тем больше итераций может потребоваться для достижения сходимости. |

| Размер обучающей выборки | Чем больше обучающая выборка, тем больше итераций может потребоваться для достижения сходимости. |

| Качество начальных весов | Если начальные веса близки к оптимальным, то количество итераций может быть меньше. |

| Выбор алгоритма обновления весов | Некоторые алгоритмы обновления весов могут требовать меньше итераций для достижения сходимости. |

Точное количество итераций для достижения сходимости в алгоритме обучения персептрона заранее неизвестно. Часто используется условие остановки, основанное на изменении ошибки или на достижении максимального числа итераций. Определение оптимального количества итераций может быть сложной задачей и требует экспериментов с разными параметрами и выборками данных.

Каковы факторы, влияющие на продолжительность обучения персептрона?

1. Сложность задачи обучения: Чем сложнее задача, тем больше времени и итераций может потребоваться для достижения оптимального результата. Если данные содержат сложные зависимости или шум, то обучение персептрона может занять больше времени.

2. Количество тренировочных данных: Чем больше данных доступно для обучения, тем лучше персептрон может выучить закономерности и классифицировать новые примеры. Если данных мало, обучение может занять больше времени и привести к переобучению.

3. Качество данных: Есть факторы, которые могут негативно влиять на процесс обучения, такие как наличие выбросов, неправильно помеченных примеров или несбалансированность классов. Эти факторы могут замедлить обучение и снизить его эффективность.

4. Параметры алгоритма обучения: Некоторые параметры, такие как скорость обучения (learning rate) или количество эпох (количество проходов по обучающей выборке), могут влиять на скорость обучения персептрона. Неоптимальные значения этих параметров могут привести к замедлению процесса обучения или нежелательным результатам.

5. Выбор архитектуры персептрона: Выбор архитектуры персептрона, такой как количество нейронов, слоев и типы функций активации, может также влиять на процесс обучения. Некорректный выбор архитектуры может замедлить обучение или привести к неоптимальным результатам.

6. Начальные веса и смещения: Начальные значения весов и смещений могут также влиять на процесс обучения персептрона. Если начальные значения недостаточно близки к оптимальным, обучение может занять больше времени.

7. Вычислительная мощность: Большой объем вычислений может потребоваться для обучения персептрона, особенно при использовании больших наборов данных или сложных архитектур. Недостаточная вычислительная мощность может замедлить процесс обучения.

8. Поставленные требования к точности: Если требуется достичь высокой точности классификации, обучение может занять больше времени, так как персептрону потребуется более точно настроиться на данные и учесть все мельчайшие детали.

Итак, продолжительность обучения персептрона зависит от многих факторов, таких как сложность задачи, количество и качество данных, параметры алгоритма и архитектура персептрона. Учитывая эти факторы и проводя анализ и оптимизацию, можно достичь наилучших результатов в обучении персептрона.

Какое количество данных необходимо для достижения оптимальной работы алгоритма обучения персептрона?

Для достижения оптимальной работы алгоритма обучения персептрона требуется определенное количество данных. Количество данных необходимо подобрать таким образом, чтобы алгоритм смог обнаружить закономерности в данных и построить модель, способную делать точные предсказания.

Если количество данных слишком мало, то алгоритм может обучиться только на ограниченном количестве примеров и не сможет обобщить полученные знания на новые данные. В этом случае модель будет подстраиваться под конкретные примеры и не сможет делать точные предсказания на данных, которые не использовались в процессе обучения.

С другой стороны, если количество данных слишком большое, то это может привести к переобучению модели. Переобучение происходит, когда модель подстраивается под каждый пример из обучающей выборки, вместо того чтобы обнаружить общие закономерности в данных. В этом случае модель будет хорошо предсказывать значения в обучающей выборке, но плохо справляться с новыми данными.

Оптимальное количество данных для обучения персептрона зависит от конккретной задачи и сложности данных. Для простых задач и небольшого количества признаков может потребоваться всего несколько сотен или тысяч примеров. Однако для сложных задач и большого количества признаков может потребоваться сотни тысяч или даже миллионы примеров. Важно подбирать оптимальное количество данных, чтобы достичь баланса между недостаточной и избыточной обучаемостью модели.

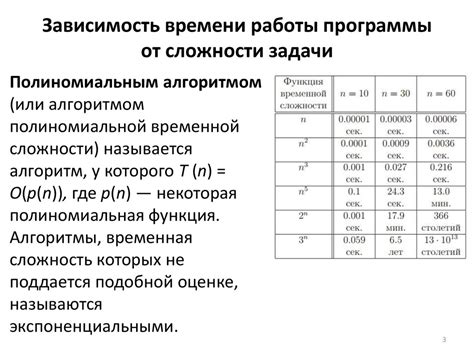

Зависимость времени работы алгоритма персептрона от сложности задачи

Сложность задачи определяется количеством признаков у объектов, а также разделимостью классов. Если задача имеет большое количество признаков или классы имеют сложные границы разделения, то алгоритму персептрона потребуется больше времени для обучения.

Время работы алгоритма персептрона можно оценить по формуле: T = N * m * k, где T - время работы, N - количество объектов в обучающей выборке, m - количество итераций обновления весов, k - среднее количество объектов, классификация которых выполняется на каждой итерации. Из этой формулы следует, что время работы алгоритма персептрона напрямую зависит от количества объектов и количества итераций.

Также сложность задачи может влиять на скорость сходимости алгоритма. Если классы объектов хорошо разделимы и данные линейно разделимы, то персептрон сходится быстрее. Однако, если задача имеет нелинейную структуру или классы перекрываются, то алгоритму потребуется больше итераций для достижения сходимости.

Итак, время работы алгоритма персептрона зависит от сложности задачи, выражающейся в количестве признаков, разделимости классов и структуре данных. Чем более сложная задача, тем больше времени понадобится для обучения модели. Поэтому при выборе алгоритма обучения необходимо учитывать сложность задачи и требуемое время для решения.

Может ли использование различных алгоритмов оптимизации ускорить процесс обучения персептрона?

Алгоритмы оптимизации играют важную роль в ускорении процесса обучения персептрона. Они определяют, каким образом будет осуществляться корректировка весов. Использование оптимального алгоритма может значительно снизить время обучения и повысить качество результата.

Один из наиболее популярных алгоритмов оптимизации для обучения персептрона – это градиентный спуск. В процессе обучения этот алгоритм ищет минимум функции ошибки, перемещаясь по градиентному направлению. Однако градиентный спуск может столкнуться с проблемой локальных минимумов и затухания градиента, что замедлит процесс обучения.

Для ускорения обучения персептрона можно использовать различные алгоритмы оптимизации. Например, алгоритмы стохастического градиентного спуска или его модификации, такие как Adam или RMSprop, позволяют достичь хороших результатов при более быстром обучении.

| Преимущества использования алгоритмов оптимизации: | Недостатки использования алгоритмов оптимизации: |

|---|---|

| Ускорение процесса обучения. | Выбор оптимального алгоритма может потребовать экспериментов и подбора гиперпараметров. |

| Улучшение качества и стабильности обучения. | Некоторые алгоритмы требуют большего вычислительного времени и ресурсов. |

| Позволяют преодолеть проблему локальных минимумов и затухания градиента. | Несколько алгоритмов могут оказаться неэффективными в определенных ситуациях. |

Окончательный выбор алгоритма оптимизации зависит от конкретной задачи и доступных ресурсов. Важно учитывать особенности алгоритма обучения и проводить эксперименты для определения наилучшего сочетания алгоритма и весовых коэффициентов, чтобы достичь наилучшей производительности и результатов обучения персептрона.

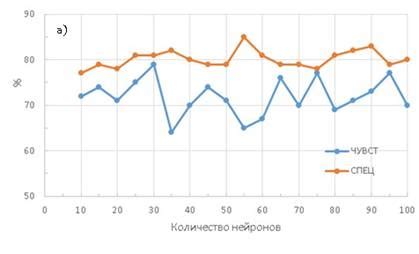

Оптимальное число нейронов в персептроне для максимальной производительности

Определение оптимального числа нейронов в персептроне является сложной задачей, так как это число зависит от различных параметров, включая тип данных, используемый для обучения, количество образцов данных и требуемую точность результата.

С одной стороны, увеличение числа нейронов может улучшить производительность персептрона, позволяя ему обработать более сложные данные и обнаружить более сложные образцы. Однако, с другой стороны, слишком большое количество нейронов может привести к переобучению модели, когда персептрон становится чувствительным к шуму в данных и теряет способность обобщать.

Для определения оптимального числа нейронов в персептроне можно использовать методы перекрестной проверки или анализа обучающих и проверочных кривых. Перекрестная проверка позволяет оценить производительность модели на независимых образцах данных и выбрать наиболее подходящий вариант. Анализ обучающих и проверочных кривых позволяет определить, при каком количестве нейронов персептрон достигает максимальной производительности.

Результаты исследований показывают, что оптимальное число нейронов в персептроне зависит от сложности задачи и объема данных. В некоторых случаях можно достичь высокой производительности персептрона, используя относительно небольшое количество нейронов. В других случаях может потребоваться использование большего числа нейронов для достижения оптимальных результатов.

Как влияет размерность входных данных на время работы алгоритма обучения персептрона?

С ростом размерности входных данных увеличивается количество параметров, которые необходимо определить в процессе обучения персептрона. Это приводит к увеличению вычислительной сложности алгоритма и увеличению времени, необходимого для его выполнения.

Однако, существуют методы и техники, которые позволяют сократить время работы алгоритма обучения персептрона при большой размерности данных. Например, применение метода стохастического градиентного спуска позволяет ускорить процесс обучения путем случайного выбора небольшого подмножества обучающих примеров.

Также важно учитывать, что качество обучения персептрона может зависеть от размерности входных данных. Слишком большая размерность может привести к переобучению модели, когда персептрон будет адаптироваться к шуму в данных, а не к их общим закономерностям. В таких случаях может потребоваться использование методов снижения размерности данных, например, методов главных компонент или методов отбора признаков.

Таким образом, размерность входных данных оказывает существенное влияние на время работы алгоритма обучения персептрона, требуя больше вычислительных ресурсов и времени. Вместе с тем, необходимо учитывать и другие факторы, такие как качество обучения и возможность переобучения модели, при работе с данным алгоритмом.